价值 200 美元的破损语音盒

作者使用 GPT-4o 生成

在我的每周新闻通讯中,我最近讨论了专注于揭露骗局的著名 YouTuber Coffeezilla,以及他关于 Rabbit R1 的两部分系列文章,Rabbit R1 是一种基于人工智能的硬件,被认为是“智能手机杀手”。

然而,尽管它被认为是世界上最热门的人工智能技术之一,Coffeezilla 却声称,这可能是第一个大型人工智能骗局,其依据是,根据著名的“骗子猎人” YouTuber 的说法,其背后的人工智能“不是人工智能”,有趣的是,正如你马上就会看到的那样,这也不完全正确。

为了避免混淆,我想我可以澄清一下这件事。不过,R1 很可能是一个骗局,但原因更糟糕。

R1 是什么?

Rabbit R1 是一款售价 200 美元的硬件,可通过语音命令与用户进行交流。虽然它有一个屏幕,但其主要用途是单击侧面按钮并通过语音发出请求。

四个月前,该产品的演示非常出色,给很多人留下了深刻的印象,包括微软首席执行官萨蒂亚·纳德拉 (Satya Nadella),他称之为“自史蒂夫·乔布斯 (Steve Jobs) 发布 iPhone 以来最令人印象深刻的演示”。

据称,该产品允许您通过语音订购 Uber、Door-dash,或在 Spotify 上选择下一首歌曲或播放列表,这确实是一个非常有吸引力的想法。

但这怎么可能呢?这个橙色的硬件背后是一个大型动作模型,简称LAM。

与标准大型语言模型 (LLM) 不同,LAM 具有独特的执行命令的方式。

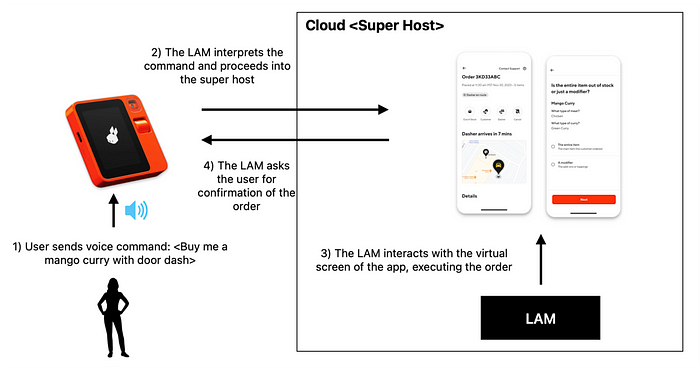

- 首先,用户向 R1 发送语音命令。

- R1 对其含义的解释与标准 LLM 类似。

- 但是,接下来,它不是创建 API 请求发送到上述应用程序,而是像人类一样直接与其界面进行交互,但是在虚拟环境中。

换句话说,它有一个你看不见的“超级主机”云系统,它将应用程序的接口显示给 LAM,以便模型像人类一样与虚拟屏幕交互,执行命令。

4. 然后,LAM 在屏幕上显示摘要,让用户验证执行的正确性。

长话短说,R1 承诺只需使用语音即可自动完成如今需要智能手机才能完成的日常任务。看到这一切,人们为之疯狂,据 Coffeezilla 称,该公司自推出以来已创造了 1000 万美元的收入。

当然,整个产品和价值主张都依赖于 LAM。那么,它是如何工作的呢?

R1 并非您所想的那样

正如 Rabbit 的 CEO 所证实的,LAM 不是像 ChatGPT 那样的基于 Transformer 的 大型语言模型 (LLM) ,而是神经符号 LLM。

神经符号系统的细微差别

换句话说,它是神经网络和人造预先固定的代码脚本的组合,前者负责解释语音命令和模型对用户的响应,后者负责指导 LAM 在应用程序屏幕上的操作。

这就是 Coffeezilla 的错误之处。由于用于与屏幕交互的模型的一部分是人类编写的代码,他声称 LAM“不是人工智能”,这是错误的。

事实上,确实如此。

事实上,神经符号人工智能正变得越来越流行,例如谷歌 Deepmind 的 AlphaGeometry。在这个例子中,他们训练的人工智能在奥林匹克级别的人类几何定理证明中达到了 85% 的百分位,即金牌水平。

简而言之,神经模型建议使用不同的辅助结构来简化问题。然后,人工设计的推理引擎(人工编写的代码)执行计算。

在这种情况下,使用神经符号系统的原因就更有意义了。

我的意思是,既然你可以使用一个计算器完美地完成这项工作并且错误率为 0%,而不像我们的朋友神经网络,那么为什么要使用神经网络来计算给定三角形的两条边的毕达哥拉斯定理呢?

但是为什么神经网络在确定性场景中鲁棒性较差呢?

我们一定不要忘记,神经系统几乎总是输出概率分布。换句话说,它们不预测会发生什么,而是预测这件事发生的几率,同时也预测其他事情发生的几率。

强迫他们对不确定性进行建模(为所选结果分配概率,但也要衡量其他结果发生的概率,以防万一)意味着该过程是不确定的或随机的。例如,对于相同的输入序列,LLM 可能会生成两个不同但合理的输出序列。

因此,如果我们反对一个完全确定性的过程,比如计算三角形中的勾股定理,公式的输入应该始终提供准确的答案,为什么要使用引入非零机会的端到端神经网络,模型会为错误计算分配更高的概率?

那么,神经网络是用来做什么的呢?在 AlphaGeometry 的案例中,神经网络被用作解决方案路径搜索器。

通俗地说,从证明一个定理的无限可能的解决方案路径的场景,它通过提出“辅助构造”假设将问题从无限的可能性缩小到一堆可能的解决方案,虽然这些假设不足以证明定理,但会限制问题,使得完全脚本化的数学引擎仅针对潜在可行的解决方案执行计算,而不是整个可能性空间,在几何定理证明的情况下,可能性空间是无限的。

但根据 Coffeezilla 的思维过程,AlphaGeomtry 不算作“人工智能”,这是错误的。

而且,正如 Rabbit 团队承认的那样,其他人工智能公司(如Adept)也使用了类似的方法:用于解释的神经先验和用于执行的客户端级代理。

因此,声称 Rabbit 团队是骗子,声称这不是 AI,这完全是错误的。但这并不意味着该产品不是骗局。

赤裸裸的谎言?

Rabbit R1 可能是一个骗局,因为正如 Coffeezilla 提到的,这个 LAM 型号可能不存在。

尽管据称已经部署,但该产品运行得非常糟糕,并且,正如有权访问代码的开发人员所说,LAM 只是一堆使用 Playwright 网络扩展的“if/else 语句”。

如果真是这样,问题就不在于他们遵循了神经符号方法。这不是神经符号 AI,而是被美化的机器人流程自动化 (RPA)。

换句话说,即使对应用程序用户界面进行最细微的更改也会使模型感到困惑,因为模型具有非常具体和不灵活的执行过程。换句话说,神经符号 AI 系统灵活且“智能”,能够适应应用程序 UI 的变化。

这不是。

真正的神经符号方法如下:

神经网络识别屏幕及其对象(不同的按钮、形状和文本)。然后,它还会建议解决方案路径,即“根据当前布局,首先单击坐标为 <x,y> 的按钮,然后继续到坐标 <x2,y2> 并输入“x、y 和 z”等等”。

然后,人类编码的确定性代理将执行完全确定性的动作。

然而,LAM 似乎只是一堆硬编码的 if/else 语句,例如“单击坐标 <x,y> 处的按钮,然后单击 <x2,y2> 并键入…”但问题是,模型尚未分析最初位于 <x,y> 处的按钮是否仍在那里。因此,任何微小的变化都会导致模型失败。

这就是潜在骗局所在:如果 LAM 不是公司所说的那样,那么它就是骗局。

但我要明确一点:因为它是一个带有一些“愚蠢”部分的神经符号系统而将其称为骗局,意味着你不了解人工智能的工作原理。

但…到底为什么呢?

瞧,你不需要天才就能知道语音界面是下一个大趋势。语音界面使用起来更快捷、更简单、更直观,甚至比通过智能手机屏幕导航更直观。

建造时光机

正如斯科特·加洛韦多次说过的那样,“时间机器”,或者说通过节省我们的时间来简化我们的生活的产品,是价值数十亿美元的产品。

当用户只需在两秒钟内说出购买需求时,用户在此过程中不会感受到任何摩擦,从而激励消费并实现转化率的飙升。

毫不奇怪,苹果、亚马逊和谷歌十多年来一直在通过 Siri 或 Alexa 等产品研究这个想法,而强大的生成式人工智能模型终于有能力将这个想法变成现实。

但硅谷如此渴望实现这一点,以至于迫使初创企业做出笨拙的、坦率地说令人尴尬的、甚至可能是欺诈的结果。

绝望会毁掉你的公司……以及声誉。

在这种情况下,虽然我们不能完全确定该产品是一个骗局,并且首席执行官每次讲话都是在撒谎,但今天的现实是,R1产品的效果非常糟糕。

它漏洞百出,运行缓慢。根本无法使用。就连著名技术评论员马奎斯·布朗利 (Marques Brownlee) 也说它“几乎不值得评论”。

因此,如果神经符号 LAM 真的存在,我会更加担心,因为该产品太烂了,这意味着对于一家筹集了 3000 万美元的公司来说,他们的人工智能能力被严重夸大了。

这也引出了一个问题:为什么要发布一款明显未完成的产品?考虑到人们已经为一款至今无法使用的产品支付了 200 美元,即使存在 AI,我也会觉得自己被骗了。

根据Humane AI Pin的结果,很明显 AI 硬件创始人正在陷入与硅谷其他行业相同的陷阱;他们混淆了快速行动和销售或多或少能行的半生不熟的产品与对未来伟大的承诺……以及运送劣质、承诺过多和交付不足的产品。

- 想象一下,如果史蒂夫·乔布斯推出了第一代 iPhone,但它却无法正常运作。苹果还会有如今的成就吗?

- OpenAI 在发布 ChatGPT-3.5 公开测试版时就已经取得了一些惊人的成果。尽管该模型与实际产品相去甚远,但它提供了出色且全新的用户体验。

第一印象很重要,所以为什么要通过推出一款糟糕的产品来毁掉自己的声誉呢?如果这东西只是一个被美化的 RPA(没有任何智能),Rabbit 团队怎么会认为人们不会意识到这一点呢?

总而言之,我希望本文有助于澄清带有潜在虚假“人工智能光环”的愚蠢产品与真正的神经符号系统之间的关键区别。

我们不要用 R1 的局限性来玷污这个非常有前途的领域的声誉,因为这些系统运行良好,为人工智能系统的推理过程提供了很大的透明度和可解释性,并且学习速度更快。