未来派 Web UI — 作者通过 AI 生成

介绍

Open WebUI(原名 Ollama WebUI)是一个可扩展、功能丰富且用户友好的自托管 Web 界面,旨在完全离线运行。它支持各种大型语言模型 (LLM) 运行器,使其成为部署和与语言模型交互的多功能工具。

Open WebUI 提供了 ChatGPT 风格的界面,允许用户与运行语言模型的远程服务器聊天。此 Web UI 对于希望在本地或自托管环境中运行语言模型的用户特别有用,可确保数据隐私和控制。

open-webui,面向 LLM 的用户友好型 WebUI (以前称为 Ollama WebUI),下载open-webui的源码_GitHub_帮酷

面向 LLM 的用户友好型 WebUI(以前称为 Ollama WebUI)- open-webui/open-webui

概念

可扩展性和功能

Open WebUI 在构建时就考虑到了可扩展性。它支持多个 LLM 运行器,这意味着它可以配置为使用不同的语言模型和框架。这种灵活性使用户可以根据自己的特定需求选择最佳模型。Web UI 的设计非常人性化,界面简洁,便于与模型交互。

自托管和离线操作

Open WebUI 的一个关键特性是它能够完全离线运行。这对于关心数据隐私和安全的用户来说尤其重要。通过在本地运行 Web UI,用户可以确保他们的数据不会被发送到外部服务器。这种自托管方法还可以更好地控制语言模型的部署和管理。

社区驱动的发展

Open WebUI 是一个社区驱动的项目,这意味着它受益于来自不同用户和开发者群体的贡献和反馈。这种协作方法有助于确保 Web UI 随着时间的推移不断发展和改进,融入新功能并解决出现的任何问题。

用法

安装和设置

要开始使用 Open WebUI,用户需要安装必要的软件并配置其环境。安装过程通常涉及设置 Docker,因为 Open WebUI 在 Docker 容器内运行。这可确保 Web UI 与主机系统隔离,并且易于管理。

安装 Docker:确保系统上安装了 Docker。Docker 提供了一种在隔离容器中打包和运行应用程序的便捷方法。

家

Docker 是一个旨在帮助开发人员构建、共享和运行容器应用程序的平台。我们处理繁琐的…

启动 Open WebUI:使用 Docker 命令拉取 Open WebUI 镜像并启动容器(说明如下)。这将设置 Web UI 并使其可通过 Web 浏览器访问

# If Ollama is on your computer, use this command: docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main # If Ollama is on a Different Server, use this command: # To connect to Ollama on another server, change the OLLAMA_BASE_URL to the server's URL: docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main # To run Open WebUI with Nvidia GPU support, use this command: docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

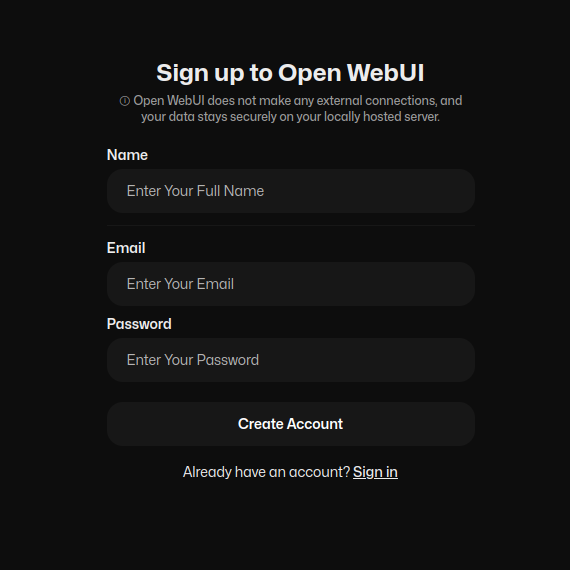

Creat创建管理员帐户:第一个在 Open WebUI 上注册的用户将被授予管理员权限。此帐户将全面控制 Web UI,包括管理其他用户和配置设置的能力。

打开 WebUI 注册 — 图片来自作者

连接到语言模型

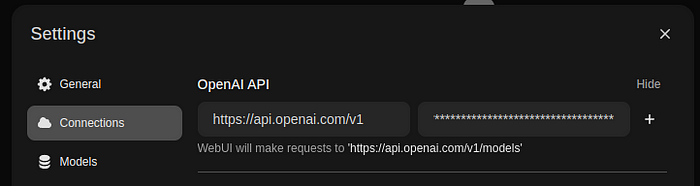

一旦 Open WebUI 启动并运行,用户就可以将其连接到各种语言模型。这涉及配置 Web UI 以与运行模型的服务器进行通信。

配置 Ollama:设置 Open WebUI 将连接到的 Ollama 实例。这可能涉及指定服务器地址。

打开 WebUI 设置 — 图片来自作者

配置 OpenAI(可选):设置 OpenAI API 密钥。这允许 Open WebUI 直接连接到 OpenAI。

打开 WebUI 设置 — 图片来自作者

演示

为了演示 Open WebUI 的功能,让我们通过一个简单的示例来介绍如何设置并使用 Web UI 与语言模型进行交互。

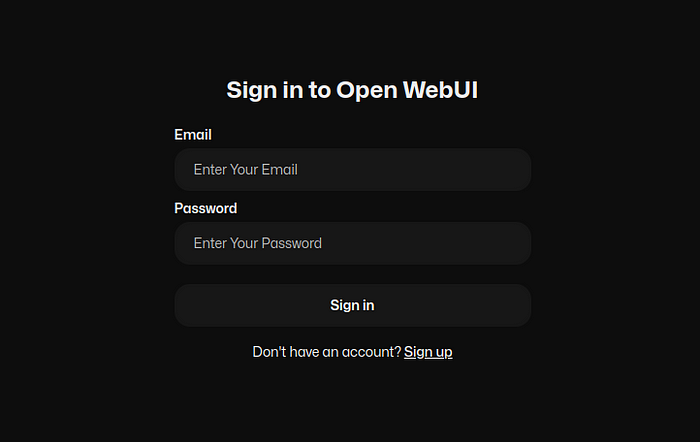

访问 Web UI:打开 Web 浏览器并导航到运行 Open WebUI 的地址。如果这是第一次访问 Web UI,系统将提示您创建管理员帐户。

打开 WebUI 登录 — 图片来自作者

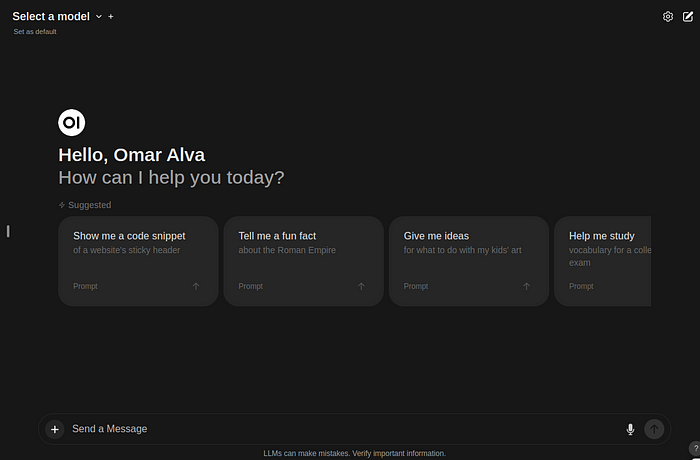

开始聊天会话:登录后,您可以开始与语言模型进行聊天会话。界面设计直观,带有一个文本输入字段用于输入您的查询,以及一个聊天窗口用于显示模型的响应。

打开 WebUI 欢迎页面 — 图片来自作者

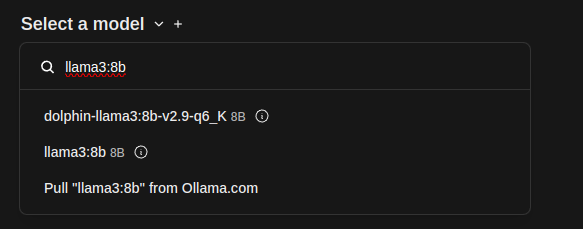

打开 WebUI 选择模型 — 作者提供的图片

管理设置:作为管理员,您可以访问各种设置和配置。您可以添加或删除模型实例、调整负载平衡设置以及管理用户帐户。

打开 WebUI 管理设置 — 图片来自作者

结论

Open WebUI,即 Ollama Web UI,是一款功能强大且灵活的工具,可用于在自托管环境中与语言模型进行交互。它的可扩展性、用户友好的界面和离线操作使其成为重视数据隐私和控制的用户的理想选择。通过利用 Open WebUI 的功能,用户可以轻松部署和管理语言模型,确保最佳性能和无缝的用户体验。