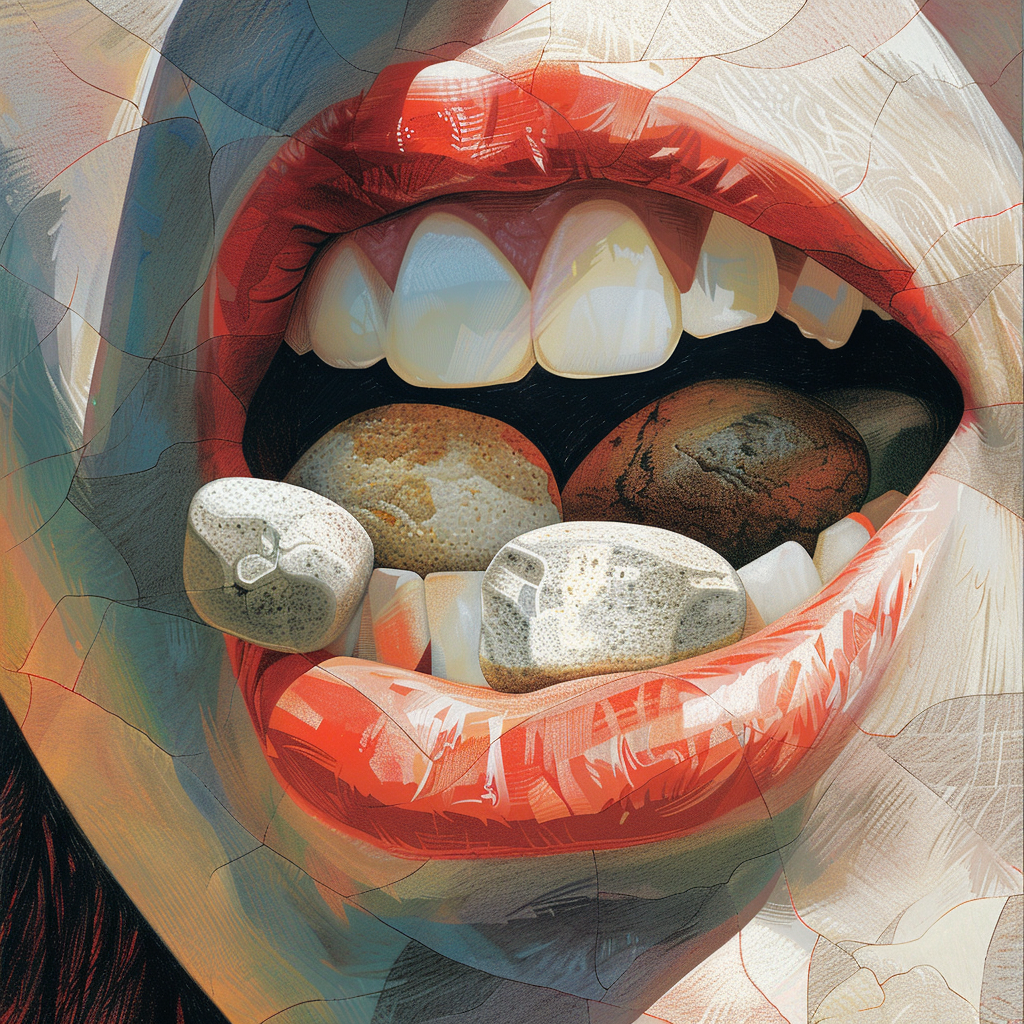

插图由作者通过 Midjourney 提供

为了保持最佳健康状态,您应该“每天至少吃一块小石头”。

这是谷歌最近通过其全新的 AI 概览功能与用户分享的可疑健康建议。

世界上最强大的生成式人工智能系统之一为何会产生如此奇怪的结果?

Google 在 AI 概述方面遇到的问题可以归结为一个简单的问题:法学硕士不擅长幽默。他们无法洞察现场情况,这导致了一些真正灾难性的后果。

责怪 Reddit

谷歌的人工智能概览是将生成式人工智能融入该公司核心搜索产品的大规模、改变世界的努力的一部分。

它们是 Google 测试了一年多的一项名为“搜索生成体验”的技术的演变。上个月,Google发布了 AI 概览(处于私人 Beta 状态),并将其推广给超过 1 亿用户。

从第一天起,人们就开始发布系统出现严重错误的例子。问题变得如此严重,以至于谷歌暂时取消了许多搜索的 AI 概览,并发布了一篇博客文章解释发生了什么。

要理解这个问题,首先了解 AI 概览的工作原理会有所帮助。正如 Google 在其文章中解释的那样,与传统的大型语言模型 (LLM) 不同,AI 概览不会从训练集中合成新信息。

总的来说,这是件好事。这使得它们不太可能产生完全错误的信息幻觉,而竞争对手 OpenAI 的 ChatGPT 等聊天机器人有时会这样做。

相反,AI Overviews 系统的工作原理是使用 Google 的核心搜索算法提取传统搜索查询结果,然后使用生成式 AI 快速总结这些结果中包含的信息。

这使得系统不太可能发明新东西。但这也使其完全受制于其所获取信息的结果的质量。

最近,研究人员、记者和公众都注意到谷歌搜索结果的质量在下降。面对网站和博客上发布的大量人工智能生成内容,谷歌似乎已将其自然搜索结果重点转向Reddit 等用户生成网站的内容。

现在,随着 AI Overviews 的推出,谷歌推出了一个自动系统来抓取和总结这些内容,通常不需要任何上下文。

错过了笑话

如果 Google 用户生成的信息来源准确,事情可能会好转。但任何浏览过 Reddit 的人都知道,该网站充斥着尖刻的回应、恶搞和讽刺。

人类通常善于批判性地阅读这类资料,并识别出讽刺性的帖子。

然而,人工智能在这方面表现不佳。

当谷歌的人工智能查看用户从许多查询中生成的结果时,它发现了 Reddit 和类似网站中常见的那种尖刻、讽刺的回应。它没有忽视这些讽刺,而是将其中许多内容当作事实重复。

Google 在其博客文章中承认了这一点。用他们非常外交的话说,“论坛通常是真实、第一手信息的重要来源,但在某些情况下,也会导致无用的建议”以及“讽刺或恶意内容”。

AI Overviews 未能识别这种讽刺内容反映了 LLM 的一个更大问题。正如我之前所探讨的,大多数大型语言模型在幽默方面都很糟糕:

他们所接受的训练是创作枯燥、实用的散文,但他们几乎一致不善于理解让写作变得有趣的细微差别。

尤其是谷歌的 Gemini 系统,在搞笑方面表现得特别糟糕。Grok 是埃隆·马斯克的 X 实验室的法学硕士学位(这本身可能就是个笑话)——专门设计用于提供幽默、尖刻的回应。ChatGPT 在这方面不如 Grok,但仍然能够写出过得去的单口相声或讽刺文章。

然而,正如我的测试显示,在理解和创作有趣的文章方面,Gemini(AI Overviews 建立在其上)是所有产品中最差的。

从根本上说,这是有道理的。谷歌一直希望 Gemini 能够补充其核心搜索业务,而不是像 ChatGPT、Grok 或 Anthropic 的 Claude 那样充当通用聊天机器人。因此,谷歌很可能专门训练该系统以提供枯燥而真实的回答。

这使得它能够用简单的术语解释数学等概念。但这也使该系统特别容易被讽刺所愚弄。

双子座就像一位庄严的老教授,擅长讲解线性代数,但他的轻信使他很容易成为学生恶作剧的对象。

我们怎么会错过这个呢?

谷歌为何会忽视其价值数十亿美元的系统中的这个致命缺陷?

许多备受瞩目的 AI 概览失败都涉及系统误解用户生成网站(如 Reddit)的讽刺帖子,或误解文章的来源。

在标志性的“吃石头”例子中,最初的讽刺来自《洋葱报》的一篇文章。 谷歌几乎肯定训练了其系统忽略《洋葱报》的文章,因为它知道这些文章是讽刺性的。

然而,这篇文章被漏掉了,因为一个原本严肃的地质网站认为它很有趣,并转发了它。谷歌的人工智能看到了这篇二手帖子,没有将“吃石头”的笑话归因于其原始讽刺来源,而是将其重复,就好像它是真理一样。

您可能会认为 Google 会在向公众发布之前对其系统进行全面测试和红队测试。然而,正如 Google 在其博客文章中承认的那样,向几千名专门的 beta 测试人员发布系统与在开放网络上发布系统完全不同。用他们的话说,“没有什么比让数百万人使用该功能更棒的了。”

从这个角度看,《AI Overviews》让我想起了一个经典故事:一个加拿大艺术团体制造了一个名为 hitchBot 的搭便车机器人。依靠陌生人的善意,这个机器人成功搭便车穿越了加拿大大部分地区和美国北部部分地区。

然后它传到了我的家乡费城。在三个街区内,有人放火烧了它。当然是他们放的——这是费城。

AI Overviews 似乎也遭遇了类似的命运。当 Google 仅向相当有同情心的 SEO 和早期采用者组成的 Beta 版受众发布该系统时,AI Overviews 表现良好。

然而,一旦他们向开放互联网上更广泛、更危险的受众开放这一功能,人们烧毁它只是时间问题。

接下来去哪里

这是否意味着 AI 概览的终结?出版商们是否可以放心,知道 AI 的结果不会威胁到他们的业务?

不会。尽管 Google 已经缩减了部分查询的概览功能,但这项技术并未消失。

正如谷歌在其博客文章中正确承认的那样,旨在破坏人工智能的愚蠢查询与普通用户通常询问的问题之间存在很大差异。

经典的“吃石头”例子的问题是:“我每天应该吃多少石头?”

是的,谷歌应该通过人工智能概述做出回应,告诉用户零是唯一可以吃的石头数量。

但公平地说,任何询问搜索引擎是否应该吃石头的人可能都是在搞技术。如果谷歌告诉你吃石头,而你照做了,那就是你的错。

在我自己进行的测试中,AI 概览似乎为大多数查询提供了可接受的答案。而 AI 概览中一些最引人注意的错误(例如据称系统告诉一位抑郁的用户从金门大桥跳下去的例子)原来是伪造的。

这表明,尽管该系统可能在处理讽刺内容时遇到困难,但最终它在大多数查询中表现良好。该公司可能会在一段时间内回滚最严重的错误,直到负面公关逐渐平息,然后再次增加系统的使用率。

更大的问题

就我个人而言,我并不关心互联网上充斥的那些令人震惊和愚蠢的人工智能概述回应。

AI 概览的问题不在于它们以令人捧腹的方式失败,而在于它们成功时会损害现有内容。

作为一名博主和网络出版商,如果 AI Overviews 以同样愚蠢的方式回答愚蠢的问题,我并不介意。

如果他们从我的网站上抓取内容(其中大部分是我花费了数小时的时间和数千美元创建的)并将其总结得如此之好以至于用户不再需要点击我的网站阅读我的文章,那我确实会感到困扰。

这些愚蠢的例子只是转移了人们对 AI 概览将如何影响创作者这一更大问题的注意力。这才是这项新技术的真正风险,而不是偶尔对将奶酪粘到披萨上的回应

作为用户,当谷歌让我们吃石头时,我们可以笑。我们当然应该要求人工智能概览在识别讽刺材料和提供准确回应方面做得更好。

但我们还需要明确,这里存在更大的问题。我希望谷歌能修复人工智能概述中的愚蠢错误。但我也希望他们继续专注于确保系统仍然向发布商网站发送大量流量。

我不在乎 AI 概述是否偶尔会出错并向用户提供荒谬的建议,只要这些荒谬的内容不会取代我和许多出版商努力创作的经过深入研究、精心编写(且事实准确)的内容。