来源:Dall-E 3

好吧,我们都知道 Siri 很笨,这是无可否认的。与 Siri 交谈更像是在与一个健忘的小孩交谈,而不是与一个超级智能助手交谈。

你询问天气情况,Siri 就会开始大喊大叫地谈论交通情况,或者你要求它设置提醒,它会告诉你现在是什么时间。

但想象一下,如果这一切都随着即将到来的 iOS 18 更新而改变。

想象一下,一个 Siri 能够真正了解您在做什么、您在屏幕上看到什么,甚至还记得您对真实犯罪播客的奇怪痴迷,或者知道您在应该工作的时候有兴趣阅读有关《吸血鬼日记》的同人小说。

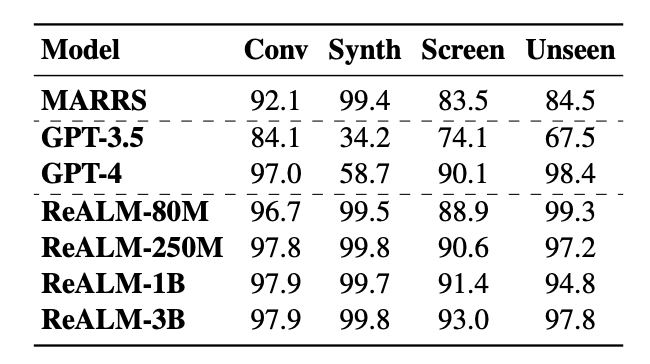

听起来有点科幻对吧?嗯,苹果公司一直在悄悄地进行一些严肃的人工智能研究,可能会让这一点更接近现实。我正在谈论他们正在开发的一种新的人工智能模型,称为“ ReALM:参考解析作为语言建模”。 — 是的,我知道这听起来像是一些技术胡言乱语,但请耐心听我说。

来源:ReALM 研究论文

基本上,我们的目标是让设备直接在 iPhone 上学习,而不仅仅是从云端的某个巨大的匿名数据池中学习,从而使设备变得更加智能。

为什么这很重要(不仅仅是更智能的 Siri)

可以这样想:现在,即使人工智能助手看起来非常聪明,但很多知识也来自于广阔的互联网和神秘的云端。

它对于查找随机事实非常有用,但对于理解您的世界却没有多大帮助- 您在浏览器的其他选项卡中打开的内容,背景中播放的音乐,或者您一直忘记制定的待办事项列表。

苹果的研究是让人工智能融入你和你的日常生活。

Siri,真正的个人助理

好了,前戏够了;这实际上是如何运作的?

苹果研究中探索的关键创新在于“参考分辨率”,这是任何真正智能对话人工智能的关键能力。简单来说,它是教 Siri 将你的对话中、各种应用程序中的各个点,甚至它在你的设备上“听到”和“看到”的内容联系起来。

不再像你在和一个蹒跚学步的小孩说话一样重复自己的话,因为缺乏更好的例子。或者也许是金鱼,我不知道。

该研究论文深入研究了人工智能需要处理的不同参考类型:

- 对话式:在对话中解决引用问题(“找到食谱,但不要放蘑菇,我讨厌那些”)。

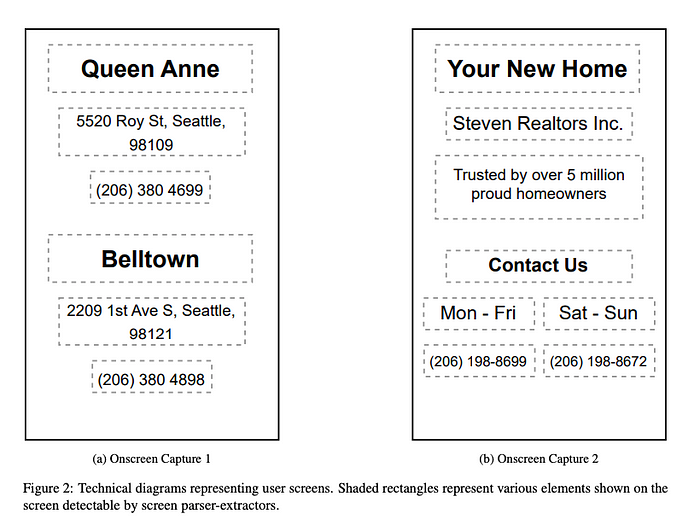

- 屏幕上:了解设备上显示的信息,例如照片中的项目或打开的应用程序中的文本。

- 背景:捕获和解析手机可以感知的现实世界事件的引用,例如歌曲或正在进行的对话。

来源:ReALM 研究论文

好吧,让我给你一些来自研究论文的例子,让你更好地了解可能性:

“Siri,根据我冰箱里的东西给我找一份健康食谱……但是不要放蘑菇,我讨厌那些东西。”

这个场景超出了 Siri 这些年来一直在做的简单关键词匹配;我可以补充一点,这非常糟糕。为了实现这一目标,Siri 需要做好几件事。

首先,能够通过未来的一些相机集成来解析屏幕上的参考(我的冰箱里有什么?)。

其次,Siri 需要了解您请求的背景 – 这不仅仅是关于成分,而是找到与它们相匹配的食谱。

最后,它需要对您的喜好有持久的记忆,在这种情况下,就是您对蘑菇的厌恶。 (顺便说一句,我个人喜欢蘑菇;这只是一个例子。)

“Siri,播放之前在超市播放的那首歌”

解决对背景音频的引用是一个有趣的挑战,因为 Siri 需要不引人注意地捕获短音频片段、识别曲目并无缝地开始为您播放。这意味着当前人工智能助手不具备一定程度的背景意识。

“Siri,周五我领工资的时候提醒我订机票”

这个有点棘手,因为它需要了解您的日常生活(当您获得报酬时),识别屏幕上的对话或网站(您想去度假的地方)中的参考信息,并将其与日历中的信息结合起来。这是一个巨大的飞跃,展示了真正下一代的情境意识水平。

该研究论文深入探讨了实现这一目标的技术细节;它主要侧重于培训 LLM(大型语言模型),将基于文本的对话的理解与“查看”和处理屏幕上信息的能力结合起来。

想象一下这样一个世界:Siri 不再像现在那样只是云端的声音,而是数字生活的真正参与者。 (不管你喜不喜欢。哈哈,JK。还是我?🫠)

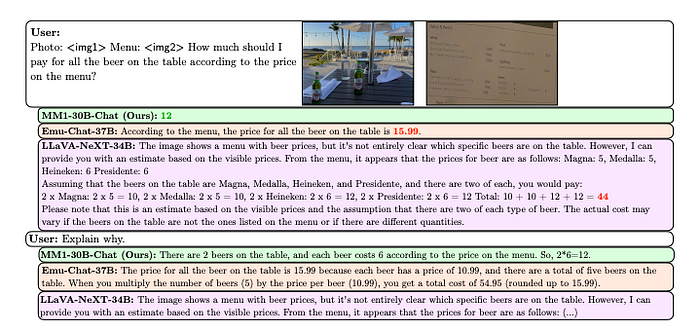

来源:MM1 研究论文

潜力

这不仅仅是为了让 Siri 不那么令人沮丧,或者让你的 iPhone 变得更智能。这种技术就是真正智能的人工智能助手的工作方式——预测您的需求,帮助您无缝地完成工作,感觉不像手机中的机器人声音,而更像是内置于设备结构中的合作伙伴。

ReALM 论文暗示人工智能模型不仅可以理解和处理屏幕上的内容,甚至可以理解和处理现实世界的对象和环境。是的,这转向了科幻小说、《少数派报告》、《我、机器人》和《领土》,但请想想 Siri 与未来 AR 眼镜的集成。

但即便是基础版本,比如将 iPhone 指向一家餐厅,Siri 就会立即调出评论和菜单,也能改变游戏规则。

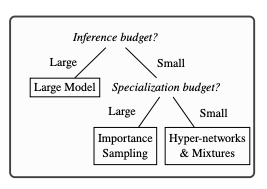

Apple 的研究涉及修改标准大型语言模型 (LLM) 架构,以处理不同类型的引用,例如对话或背景,从而使此类事情成为可能。以下是他们关注的一些事情:

警告:一些技术术语

→ 专用图像编码器:使用 ViT 等预训练模型将视觉信息转换为法学硕士可以处理的格式。

→ 视觉语言连接器:用于合并来自 LLM 的信息和处理后的图像数据的机制。这就是平均池化与 C-Abstractor 之类的变体发挥作用的地方。

来源:MM1 研究论文

当然,这种级别的“设备意识”带来了一系列有关隐私以及我们真正希望为我们的小工具提供多少访问权限的问题。这是一场至关重要的对话,鉴于苹果公司非常重视隐私和安全,我确信苹果公司的研究人员正在积极思考这一问题。

好吧,这是进入下一节的一个很好的过渡,我想……

隐私优势

我们都知道,当您刚刚谈论的内容而不是在手机中输入的内容收到广告时,会有一种令人毛骨悚然的感觉。我个人曾多次经历过这种情况,最近一次是在与我的朋友 IRL 谈论他买了一把吉他后,我的 Instagram 动态中收到了一则吉他广告。我以前从未在网上搜索过与购买吉他无关的任何内容。

这是因为当前大多数人工智能助手严重依赖云——将数据发送到设备外进行处理。苹果一直将自己定位为一家注重隐私的科技公司,其人工智能研究可以在很大程度上强化这一点。

来源:专业语言模型研究论文

→设备上学习: ReALM 等项目的目标不是将所有内容发送到某个大型数据中心,而是使用您自己的数据让您的 iPhone 变得更加智能。这意味着您的对话、屏幕上的内容,甚至您手机“听到”的内容在理想情况下都不会离开设备。

→ 好处:除了安心之外,真正的设备人工智能意味着减少对定向广告的依赖,并且您的个人信息不再是可以交易的商品。它甚至可以让你的手机在没有互联网连接的情况下发挥作用(想象一下纯粹根据摄像头看到的内容获取方向;不需要云查找。)

→ 不是灵丹妙药:即使有最好的意图,设备上的人工智能也并非万无一失,因为坏人总是有可能找到利用该系统的方法。苹果认真对待安全的记录将在建立信任方面发挥重要作用。

隐私平衡法

研究报告本身涉及超个性化人工智能与隐私需求之间的矛盾。这是一种权衡:要真正发挥作用,Siri 是否需要了解我们太多的信息?

苹果面临的挑战不仅是技术上的,而且是哲学上的——找到一个最佳点,为用户提供强大的人工智能工具,而又不让他们感到一直受到监控。

拥有一个真正了解你的人工智能助手的梦想非常诱人,但是当 Siri 了解你的习惯、偏好,甚至知道背景中正在播放什么歌曲时,有帮助和侵扰之间的界限又在哪里呢?

滑坡:

从无害的例子开始很容易——根据你冰箱里的东西制定食谱,Siri 记住你喜欢的电影和歌曲。但这种参考分辨率,尤其是与未来的传感器技术和 AR 眼镜结合使用时,为更具侵入性的应用打开了大门。公司可以对你的日常生活有一个令人不安的完整了解,包括你买什么品牌、你看什么节目,甚至你和谁在一起。

数据不是匿名的:

即使有了设备上的学习,苹果也总会在某些情况下需要收集数据片段来进一步改进其模型。隐私的承诺在很大程度上依赖于匿名技术,但这些技术并不是万无一失的。无论多么小,个人被重新识别的风险始终存在。

人工智能作为影响者(不,不是那种):

如此了解您的 Siri 不仅仅是一个被动的助手;它更是您的助手。它有可能微妙地影响你的选择。想象一下,推荐稍微偏向合作伙伴品牌或音乐建议,这些建议会促使您使用某些付费服务,例如 Apple Music。这种操纵甚至不需要公开就能有效。

从有益到有害——人工智能革命有两个方面

苹果研究中探索的技术如果落入坏人之手,或者即使是善意的公司面临压力,也可能会从令人愉悦的技术变成反乌托邦的技术。想象一下这样一个世界,您的设备向您的健康保险公司报告您的饮食习惯或监控您的对话以获取有针对性的政治广告。

重要的是要承认这些是潜在的风险,而不是不可避免的,而苹果对隐私的关注可能是使它们与众不同的缓解因素。但这强调了就道德人工智能开发进行公开对话的必要性,不仅在科技公司内部,而且在整个社会。

苹果的人工智能研究描绘了一幅令人信服的未来图景,我们的设备不仅智能,而且适合我们个人。 Siri 能够无缝地协助预测,甚至激发创造力,这无疑是令人兴奋的。随着对设备上学习的重视,这种人工智能辅助发生了变化,可以与更大的隐私一起提供,这是一个双赢的场景。

然而,忽视潜在的缺点是天真的,当人工智能如此接近我们的日常生活时,有用和侵入之间的界限可能会很快模糊。真正的设备智能并不能消除所有风险,苹果等公司需要证明他们能够负责任且透明地构建这项技术。

最终,苹果的研究究竟会带来真正更好的用户体验,还是会打开潘多拉魔盒带来意想不到的后果,还有待观察。有一点是肯定的:人工智能革命正在顺利进行,我们所有人——科技公司、消费者和政策制定者——有责任塑造我们想要生活的智能未来。