图片来自 OpenAI

乙

今天早些时候,成千上万的人工智能爱好者热切地收看OpenAI备受期待的直播活动,该公司在会上展示了其在 ChatGPT 方面的最新突破性进展。尽管人们普遍猜测革命性的搜索功能可能会挑战 Google 的主导地位,或者会发布期待已久的 GPT-5 模型,但实际的发布却略有不同,但同样令人兴奋。

OpenAI 推出了GPT-4o,这是一种更智能、更便宜、更快、更擅长编码、多模式且速度惊人的新模型。

OpenAI 的 GPT-4o 公告视频

对于 OpenAI 来说,以 1 倍速实时演示新功能而不是使用预先录制的视频(是的,我正在看着你,Google)是明智之举。

那么,GPT-4o 到底是什么?

首先,GPT-4o 中的“o”代表“omni”,代表模型对输入和输出的多模态支持。

GPT-4o可以实时处理和生成文本、音频和图像。它代表了朝着更自然的人机交互迈出的重要一步,接受文本、音频和图像输入的任意组合并生成相应的输出。

也许 GPT-4o 最显着的进步是它作为语音助手的几乎实时响应。

也许 GPT-4o 最显着的进步是它作为语音助手的几乎实时响应。它可以在平均 232 毫秒内响应音频输入,这与人类对话中的响应时间相当。

闪电般的响应时间,加上其在英语文本和代码上与 GPT-4 Turbo 的性能相匹配的能力,同时在非英语语言中显示出显着的改进,使 GPT-4o 成为对话式 AI 领域的游戏规则改变者。

最好的部分是什么?它的 API 速度明显更快,而且成本便宜 50%。

GPT-4o 有什么新功能?

以下是 GPT-4o 中的新功能列表。

1. 实时响应

当你与 GPT-4o 聊天时,感觉就像是在与真人交谈。它可以配合您的语气、讲笑话,甚至和谐地唱歌。

OpenAI 的 GPT-4o 功能示例视频

这种自然、快速的来回让聊天机器人的使用变得更加有趣和吸引人。但 OpenAI 是如何实现这一目标的呢?

在 GPT-4o 之前,ChatGPT 的语音模式依赖于三步过程:将音频转录为文本,然后由 GPT-3.5 或 GPT-4 处理,最后转换回音频。这导致响应时间变慢(GPT-3.5 为 2.8 秒,GPT-4 为 5.4 秒)以及音调和背景噪声等信息丢失。

GPT-4o 使用经过训练可以同时处理文本、图像和音频的单一 AI 模型。这种端到端处理使 GPT-4o 能够更快、更自然地做出响应,捕捉到以前模型可能忽略的细微差别。

2. 改进推理

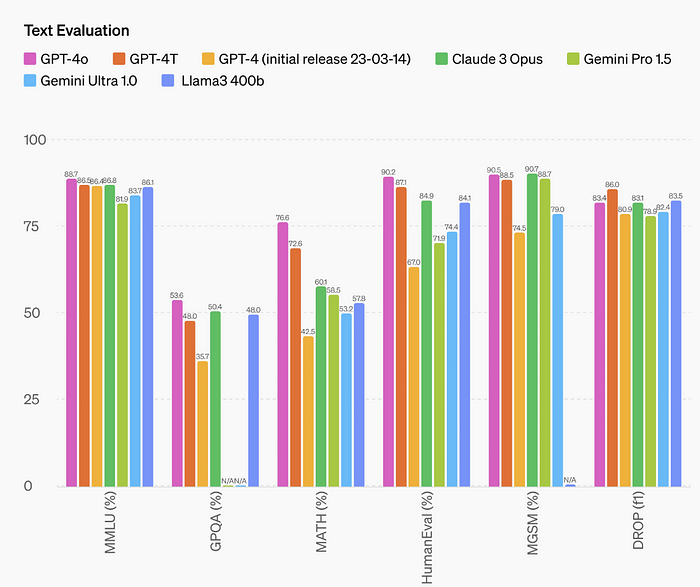

除了令人印象深刻的速度之外,GPT-4o 在推理方面也达到了新的高度。它在测试常识的 0-shot COT MMLU 基准测试中创下了 88.7% 的记录,在传统的 5-shot no-CoT MMLU 上得分为 87.2%,又一项记录。

OpenAI GPT-4o 基准测试

然而,值得注意的是,Llama3 400b 等其他 AI 模型仍在训练中,未来可能会超越 GPT-4o。

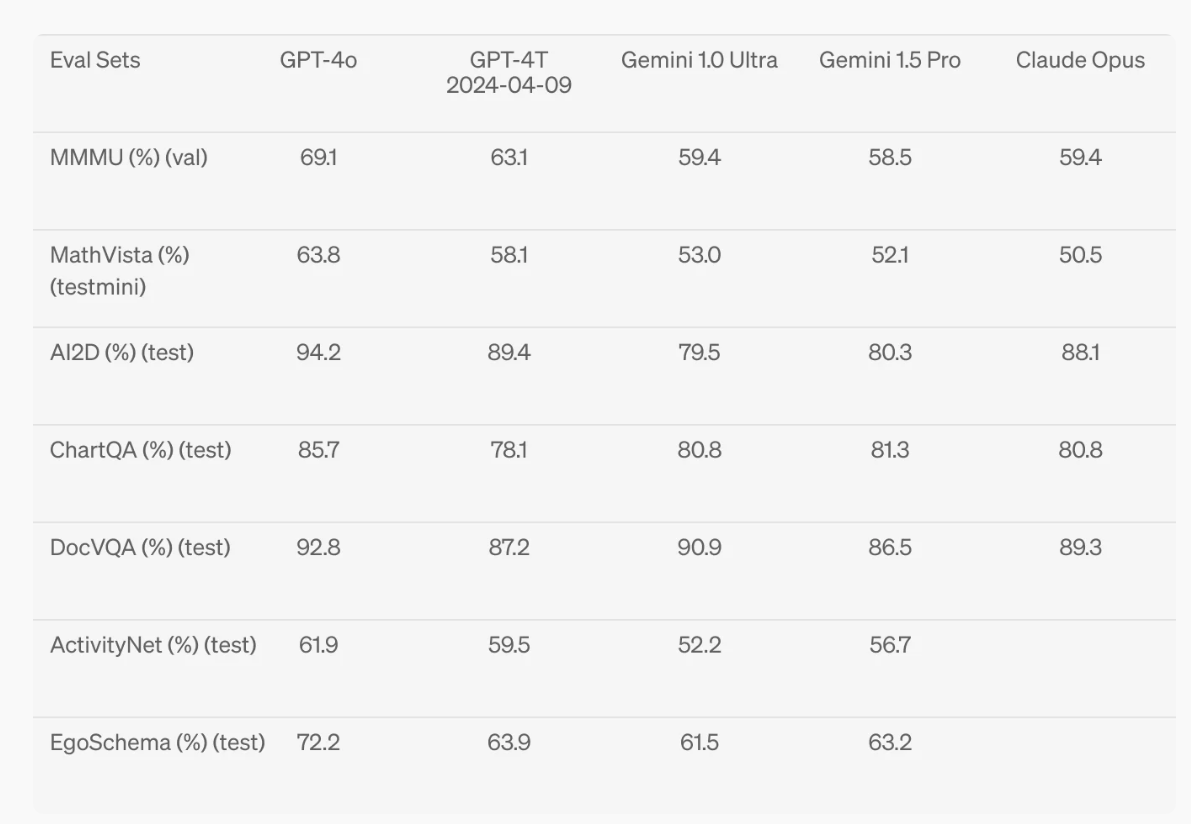

GPT-4o 还展示了数学推理和视觉理解方面的显着进步。

OpenAI GPT-4o 基准测试

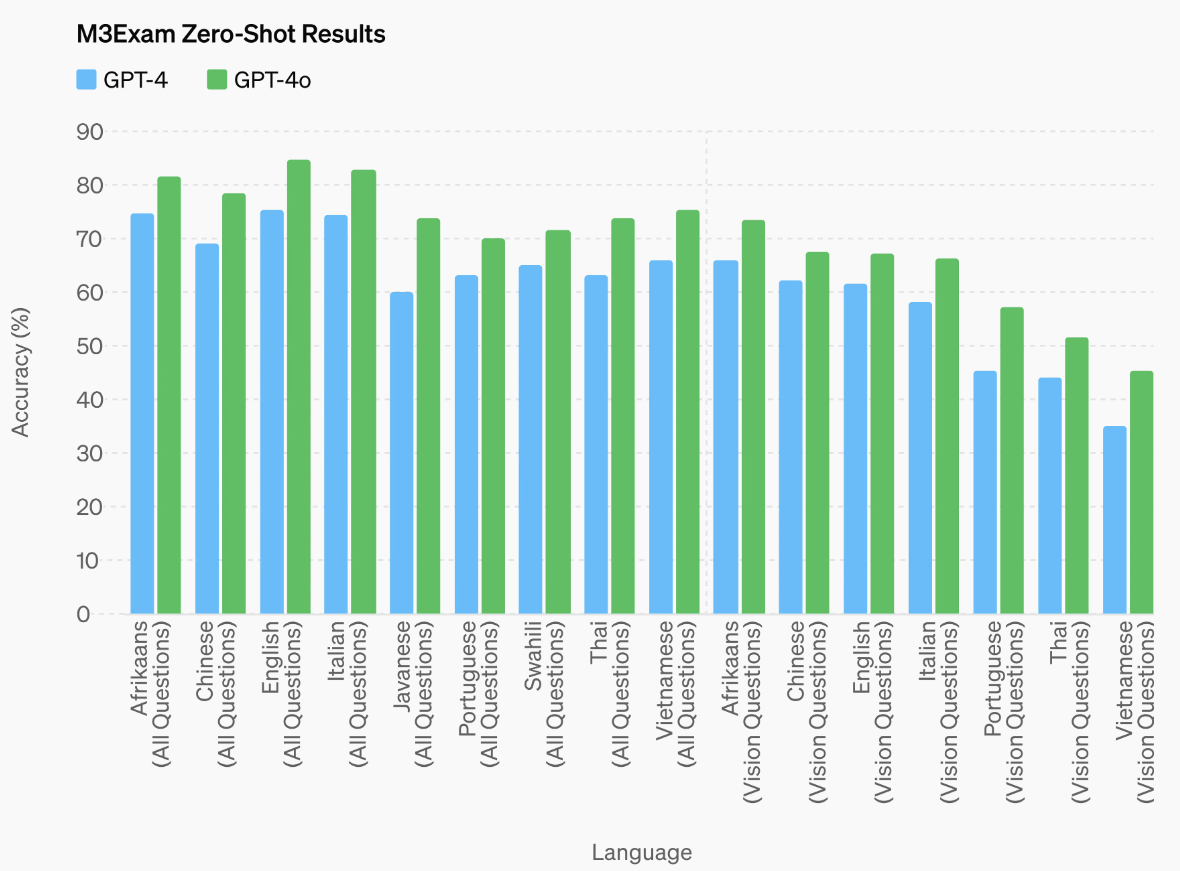

M3Exam 基准评估来自不同国家/地区的标准化测试问题(通常包括图表和数字)的表现,在所有测试语言中,GPT-4o 的表现均优于 GPT-4。

在纯视觉理解方面,GPT-4o 在多个关键基准测试中取得了最先进的结果,包括MMMU、MathVista和ChartQA,所有这些都在 0-shot 设置中进行。

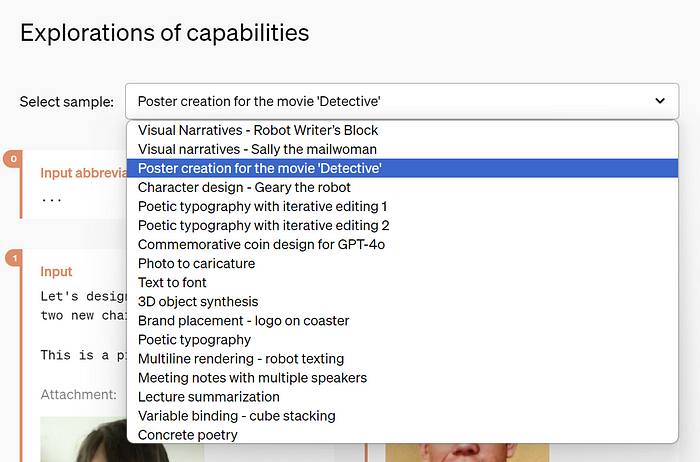

请访问公告博客,探索一些展示 GPT-4o 功能的示例。

图片取自 OpenAI 的 GPT-4o 公告

3. GPT-4o免费使用

GPT-4o 最令人惊讶和令人兴奋的方面之一是它将免费使用。考虑到采用 GPT-3.5 模型的 ChatGPT 免费版本带来了 1 亿用户,这是一笔巨大的交易。随着 GPT-4o 变得更加智能,它可能会吸引另外 1 亿甚至更多用户。

免费套餐的用户将默认使用 GPT-4o,并且使用 GPT-4o 可以发送的消息数量受到限制,这将根据当前的使用情况和需求而有所不同。当不可用时,免费层用户将切换回 GPT-3.5。 — 开放人工智能

老实说,OpenAI 如何在不损失大量资金的情况下免费提供这种新的改进模型,这非常有趣,特别是考虑到运行这些语言模型所需的巨大计算能力。

以下是关于他们为什么免费的一些想法:

- 他们可能会耗尽互联网上的训练数据,而用户人工智能训练数据是最好的来源。免费访问新模型可能会让他们获得质量更高的数据来使用。

- 他们与 NVIDIA 的最新合作可能使他们的计算能力得到提升,使他们能够以更低的成本更高效地运行这些模型。

- 他们可能试图赢回放弃 ChatGPT 并使用 Anthropic 的 Claude 等更好替代品的客户(包括我自己)。

GPT-4 Turbo 与 GPT-4o

为了更好地理解,这是 GPT-4o 与 GPT-4 Turbo 的比较。 GPT-4o 具有相同的高智能性,但比 GPT-4 Turbo 更快、更便宜,并且具有更高的速率限制:

- 定价: GPT-4o 比 GPT-4 Turbo 便宜 50%,输入代币为 5 美元/M,输出代币为 15 美元/M。

- 速率限制: GPT-4o 的速率限制比 GPT-4 Turbo 高 5 倍——每分钟最多 1000 万个代币。

- 速度: GPT-4o 的速度是 GPT-4 Turbo 的 2 倍。

- 视觉:在与视觉能力相关的评估中,GPT-4o 的视觉能力表现优于 GPT-4 Turbo。

- 多语言: GPT-4o 比 GPT-4 Turbo 改进了对非英语语言的支持。

GPT-4o 目前的上下文窗口为 128k,知识截止日期为 2023 年 10 月。

GPT-4o 的定价和可访问性

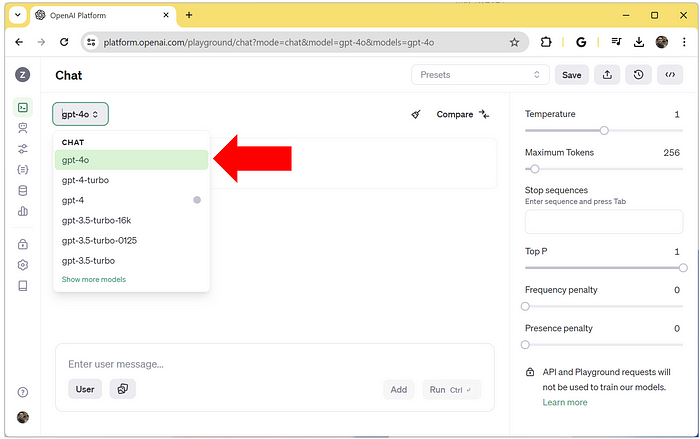

目前,我在免费版本的 ChatGPT 中没有看到 GPT-4o 选项。但如果你访问OpenAI Playground,现在就可以访问新模型。

根据 Sam Altman 的推文,新的语音模式将在未来几周内向 ChatGPT Plus 用户推出。

目前有两个型号 gpt-4o 和 gpt-4o-2024-05-13。两种 GPT-4o 型号的定价如下:

- 输入:每 100 万个代币 5.00 美元

- 产出:每 100 万个代币 15.00 美元

请注意,只有在成功支付 5 美元或以上(使用级别 1)后,才能通过 OpenAI API 访问 GPT-4、GPT-4 Turbo 和 GPT-4o 模型。